Computing

HPC/HTC-Computing

Schematic view of the WLCG around the globe

Themen für BSc-Arbeiten

1) Analyse der ATLAS HammerCloud Auto-exclusion Metadaten zur Ausfallprävention

Die Funktionalität der Rechencluster des ATLAS-Experiments im weltweiten LHC-Computing-Grid (WLCG) wird durch eine große Anzahl experiment spezifischer Tests-Jobs verifiziert. Diese Jobs werden von der HammerCloud-Testinfrastruktur gesteuert und überwacht. HammerCloud ATLAS führt verschiedene Funktionstests durch und überprüft kontinuierlich den Status der jeweiligen Rechencluster durch repräsentative MC-Simulationen (PFT) und Analyse-jobs (ATF). Wenn diese Testjobs fehlschlagen, wird die Site automatisch vom zentralen ATLAS-WFMS (Workflow Mangement System) ausgeschlossen und beim erneut erfolgreichen Testjobs, werden die Sites wieder online genommen. Die jeweiligen Entscheidungen warum, wann, welche Site aus der Produktion herausgenommen wurde, wird archiviert. In diesem Projekt wollen wir die Gesamtheit der Daten genauer analysieren um damit Anomalien oder äußere Faktoren für Störfälle besser vorhersagen zu können. Im Ersten Schritt der Arbeit müssen die vorliegenden Daten vorbereitet werden, dann sollen diese visuell aufbereitet und letztendlich analysiert werden. Das Projekt soll vollständig in Python durchgeführt werden. Grundlagen in Anwendung von Jupyter-Notebooks und rudimentäre Python-Kenntnisse sind erwünscht.

BSc Themen innerhalb des AUDITOR Projekts

Steigende Anforderungen an die Datenverarbeitung und Bedenken hinsichtlich der Energieeffizienz bei Höchstleistungen und Throughput Computing sind treibende Kräfte bei der Suche nach effizienteren Wegen vorhandene Ressourcen zu nutzen. Zum Beispiel könnte man Ressourcen eines nicht ausgelasteten Clusters mit einem Cluster teilen, der ständig ausgelastet ist und sogar weitere Ressourcen gebrauchen könnte.

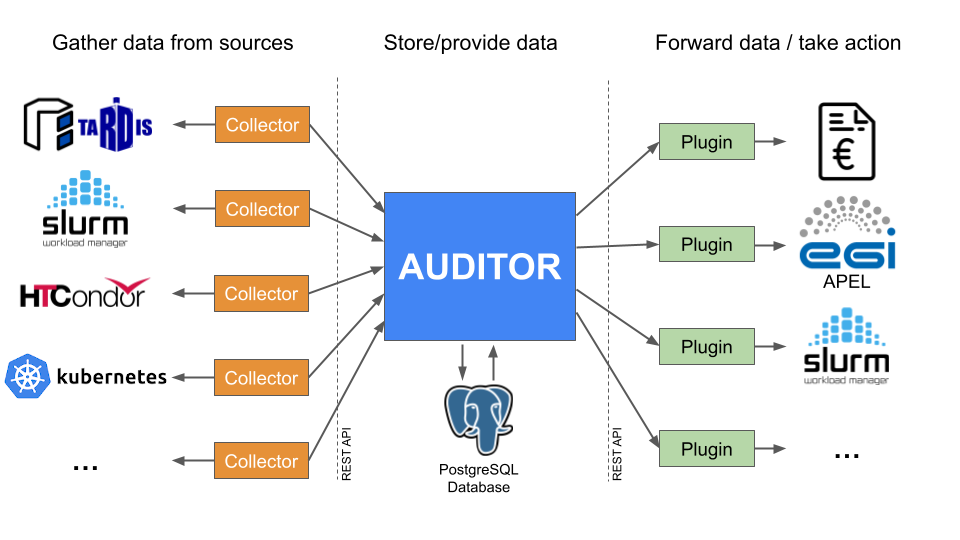

Die Software COBalD/TARDIS kann solche Ressourcen dynamisch und transparent integrieren und wieder freigeben. Allerdings erfordert die gemeinsame Nutzung von Ressourcen auch eine geeignete Buchhaltung (accounting). AUDITOR (Accounting Data Handling Toolbox for Opportunistic Resources) ist ein modulares Accounting-Ökosystem, das ein breites Spektrum solcher Anwendungsfällen mit unterschiedlichen Infrastrukturen abdecken kann. Die Erfassung der Accountingdaten erfolgt über sogenannte Kollektoren, die Batch-Systemen, COBalD/TARDIS, Cloud-Scheduler oder andere Informationsquellen überwachung und die Daten an AUDITOR weiterleiten können. Die Daten werden in einer Datenbank gespeichert und der Zugriff auf die Daten wird durch die Kernkomponente von AUDITOR verwaltet. Eine REST-API, bzw. zwei Client Komponenten, bereitgestellt in den Programmiersprachen Rust- und ein Python ermöglichen den Zugriff auf die Daten. Sogenannte Plugins können auf Basis der Accountingdaten Maßnahmen ergreifen. Je nach Anwendungsfall wählt man einen passenden Collector und ein passendes Plugin aus einer wachsenden Auswahl des Ökosystems aus. Um die Entwicklung von Collectoren und Plugins für zu erleichtern werden Bibliotheken für die Interaktion mit AUDITOR bereitgestellt.

2) Belastungstests und Simulation von AUDITOR

Um möglichst realistische Belastungstests durchführen zu können, soll in diesem BSc-Projekt ein pseudo-Collector entwickelt werden, der basierend auf einem Datenbank dump viele Auccountingdaten in kürzester Zeit an AUDITOR sendet. Damit soll die Eingangsrate bestimmt werden und ggf. Konfigurationsparameter optimiert werden. Ausserdem soll die maximale Leserate bestimmt werden, dies kann mit einem pseudo-Plugin geschehen, welches wiederum möglichst viele Daten zur Weiterverarbeitung von AUDITOR ausliest. Basierend auf den historischen Daten, soll auch ein Algorithmus entwickelt werden um Eingangsdaten zu simulieren.

3) Utilization Report Plugin für AUDITOR

AUDITOR wird bereits genutzt um die Nutzung des lokalen Rechenclusters zu optimieren.

In dieser Arbeit soll es darum gehen, Nutzerdaten auszuwerten. Das Hauptaugenmerk soll dabei auf die effiziente Ausnutzung der angefragten Ressourcen liegen. Wurden die angefragten Ressourcen gut ausgenutzt, oder hat der/die Nutzer/in Ressourcen verschwendet. Sollte dies der Fall sein, soll automatisch eine Empfehlung für die Ideal Nutzung der Ressourcen berechnet werden und der/die Nutzer/in bereitgestellt werden. Um ein allgemeines Verständnis der verwendten Ressourcen zu erzeugen und gegebenfalls ein Problembewusst sein, bei Ressourcen Verschwendung soll jedem/r Nutzer/in eine Monatsbilanz umgerechnet in CO2 Ausstoß übermittelt werden.